Au terme d’une enquête de deux ans, l’agence de la sécurité routière américaine (NHTSA) indique, que dans certaines circonstances, la fonction de conduite assistée des véhicules Tesla peut se prêter à une mauvaise utilisation, augmentant le risque de collision.

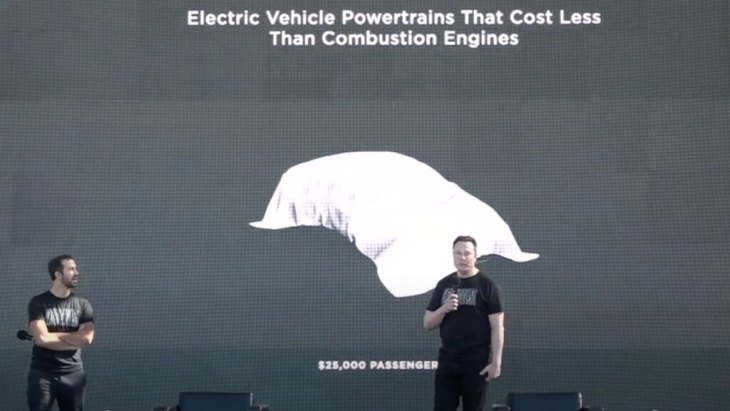

Trois options sont proposées aujourd’hui à l’achat par le constructeur : le système Autopilot de série, gratuit, qui comprend un régulateur de vitesse et une aide au maintien sur la voie. Deux autres options, payantes cette fois, sont aussi proposées : l’Autopilot «amélioré» payant, qui permet cette fois de changer de voie grâce à un composant appelé Autosteer, mais aussi de sortir d’une place de parking ou d’y rentrer sans conducteur. Et pour finir, Tesla propose une dernière option intitulée «capacité de conduite entièrement autonome», soit en anglais «full self driving» (FSD). Sur cette dernière, la firme d’Elon Musk promet une reconnaissance et une réaction de la machine aux feux de signalisation et aux panneaux stop. Face à un risque accru de «risque de collision», Tesla a toutefois dû désactiver cette option qui permettait aux voitures de ne pas marquer un arrêt complet dans certaines conditions.

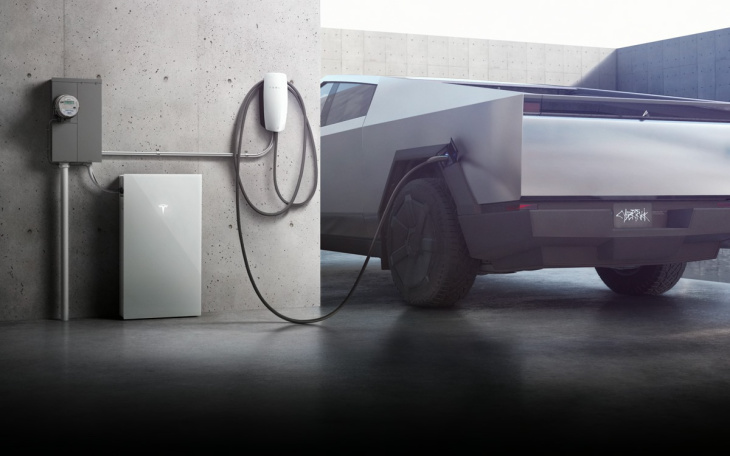

» LIRE AUSSI – Le Cybertruck de Tesla, entre objet innovant et caprice futuriste

Ambiguïté sur le degré d’autonomie des véhicules

La NHTSA affirme aujourd’hui qu’il peut y avoir un risque accru d’accidents dans les situations où le système Autopilot est engagé sans la vigilance du conducteur. Soit lorsqu’il ne conserve pas le contrôle du véhicule et qu’il n’est pas prêt à intervenir ou bien lorsqu’il ne reconnaît pas quand le système est annulé ou non. En clair, les conducteurs ont tendance à confier à tort la conduite au système en n’ayant plus les mains sur le volant. Il est vrai que Tesla entretient l’ambiguïté sur le degré d’autonomie de ses véhicules dotés de logiciel ce qui contribue largement à leur dangerosité. L’entreprise a d’ailleurs reconnu en octobre dernier que le ministère américain de la Justice avait émis des citations à comparaître concernant ses systèmes Full Self-Driving (FSD) et Autopilot.

Les dirigeants de Tesla ont déclaré n’être pas d’accord avec l’analyse de la NHTSA. Mais ils déploieront une mise à jour logicielle à distance qui «incorporera des contrôles et des alertes supplémentaires à ceux qui existent déjà sur les véhicules concernés afin d’encourager le conducteur à adhérer à sa responsabilité de conduite chaque fois qu’Autosteer – un composant d’Autopilot est engagé.»